Vše začalo v roce 1936, kdy britský matematik Alan Turing představil práci, v níž zavedl pojem Turingova stroje, teoretického modelu obecného výpočetního stroje neboli dnešních počítačů. Jeho práce našla využití během válečných let, kdy Turing pracoval pro britskou vládu a soustředil se na kryptoanalýzu německého šifrovacího stroje Enigma. Jeho myšlenka je ve své podstatě jednoduchá. Porazit stroj můžete jen tak, že vyrobíte ještě lepší stroj, který obsáhne všechny stavy svého protivníka. Tak byly položeny základy moderních počítačů, včetně neustálé potřeby zvyšovat jejich výkon.

Každého by asi napadla otázka, co se stane, až bude počet stavů onoho výpočetního stroje vyšší než počet kombinací lidských neuronů. Proto v roce 1950 představil dnes už notoricky známý Turingův test s oddělenými místnostmi, kdy člověk přes prostředníka komunikuje s druhou stranou. Pakliže není schopen rozlišit, jestli je protistrana člověk, nebo počítačový systém, může být tento systém označen za inteligentní.

Dodnes hojně citovaný a známý myšlenkový experiment vydržel v platnosti pouhých 16 let. V roce 1966 představili na MIT chatbot ELIZA. V porovnání s dnešními systémy to byla spíše parodie, kdy chatbot příliš nechápe kontext a neustále se snaží stočit konverzaci jiným směrem, třeba tak, že na otázku odpovídá otázkou. Přesto však záznamy konverzace s ním vypadají „reálně“ v tom smyslu, že někteří lidé začali věřit tomu, že se jedná o skutečné vědomí.

Znamenalo to, že vědomí a inteligence jsou jenom jednoduchý počítačový program? Odstranit tento rozpor mělo vysvětlení, kterému se říká ELIZA Effect. Jedná se o tendenci nevědomě předpokládat, že chování počítače je analogické chování člověka. Jde tedy o antropomorfizaci, polidšťování neživých objektů. V podstatě jde o přirozené fungování lidské mysli, která je náchylná vyčíst z řetězců symbolů (zejména slov) poskládaných počítači mnohem více smyslu, než kolik skutečně mají. Jako nejjednodušší příklad se uvádí bankomat, který vám na konci transakce poděkuje a popřeje hezký den. Je snadné věřit tomu, že stroj je „skutečně rád“, že jste využili jeho služby, i když jen vypisuje textové řetězce ze své paměti na obrazovku. Pojem ELIZA Efekt si zapamatujte, dnes je totiž důležitější než kdykoli předtím.

Potřeba širšího rámce

Můžeme tedy snadno shodit jakoukoli snahu o inteligentní komunikaci strojů s tím, že je jen pokládáme za inteligentní a vědomou? Situaci se v roce 1980 snažil vyřešit (nebo spíš zkomplikovat) filozof John Searl. Jeho Argument čínského pokoje je variací na Turingův test. Pracuje s místností zaplněnou čínskými texty, ve které sedí člověk, který tento jazyk neovládá. Když ale dostane nějakou otázku v čínštině, je schopen k ní najít ve slovníku odpověď a poslat ji zpět. Pracuje tedy pouze se symboly, čistě mechanicky, aniž by měl pochopení pro to, co dělá. Tazatel ale snadno získá dojem, že čínsky umí.

Nejdůležitější pro posun myšlenkového paradigmatu není ani tak samotný čínský pokoj jako spíše jeden z protiargumentů. Nesmíme totiž vnímat jen schopnosti samotného člověka, ale i celého systému, tedy osoby ve spojení se slovníky. Žádná komponenta sama o sobě čínsky mluvit nezvládne, ale systém ano.

Zatímco před čtyřiceti lety se jednalo kvůli výkonu tehdejších počítačů spíše o filozofický problém, dnes je to všední realita. Představte si, že při svém putování po Řecku narazíte na tavernu tak autentickou, že tamní obsluha nebude mluvit jinak než řecky. Co uděláte? Vytáhnete svůj telefon a pustíte hlasový překladač – a i přes drobné zádrhely se nejspíše doberete k cíli. Znamená to tedy, že umíte řecky? Rozhodně ne. Co když ale o sobě přestanete přemýšlet jako o jednotlivci, ale o části systému, který zahrnuje nejen vás, ale i hardware telefonu, mobilní sítě, servery a software Googlu? Na to už taková jednoduchá odpověď není.

Kdy už konečně nastavíte zrcadlo?

Dalším oblíbeným testem, který má zjistit přítomnost vyššího vědomí, je jednoduchý pohled do zrcadla. Populární je zejména proto, že se používá hlavně u zvířat. Většina se totiž domnívá, že na „druhé straně“ vidí dalšího zástupce stejného druhu. Člověk a lidoopi, delfín, kosatka, sloni, kůň nebo straka obecná jsou však schopni rozpoznat, že jde o ně samé, což by nebylo možné bez toho, aniž by si nebyli vědomi vlastní existence.

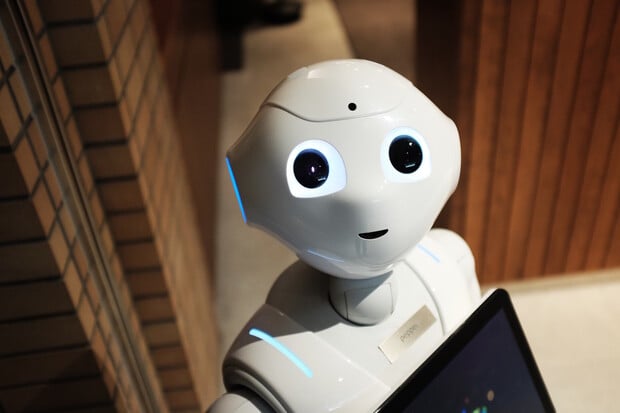

Ale pozor – deset let starý experiment, o kterém informovala BBC, ukazuje, že lze naučit roboty, jak testem projít. To však není překvapivé vzhledem k tomu, že podobně lze vytrénovat i zvířata. Zdá se, že ani nastavené zrcadlo nám nepomůže rozhodnout, kdo je a není vědomý, ale přesto je to důležitý střípek do skládačky toho, co právě prožíváme.

Každý kontakt s dnešními chatboty je totiž jako pohled do zrcadla. V něm se odráží celá kolektivní „moudrost“ textů, na kterých AI trénovala, což vysvětluje, proč byly některé rané pokusy tak násilnické a vulgární. A také osoba samotného tazatele. Jak?

Představte si, že ChatGPT a další podobné jazykové modely byly trénovány například na sociální síti Reddit, jakémsi ohromném diskusním fóru. Jejich úroveň se velice liší: někde běží kultivované akademické diskuse, jinde zase zuří „flamewary“, kde si lidé víceméně jen navzájem nadávají špatnou angličtinou. Chatboti jsou trénováni tak, aby se co nejvíce přizpůsobili své protistraně právě v jazykovém projevu.

Hledím do zrcadla a vidím Elizu

Kombinaci ELIZA Efektu a špatně pochopeného odrazu v zrcadle vidíme prakticky v každém článku, který popisuje kontakt s nějakým vyspělým chatbotem. A to i u seriózních médií. Novinář z New York Times předvedl žánrový veletoč, kdy donutil AI nejdříve tvrdit, že chce vyhladit lidstvo, aby pak během pár chvil neopětoval její lásku. To je podle novináře uznávaného listu důvod pro to, proč už „svět nebude jako dřív“.

Jako v Minority Report. Umělá inteligence má vymýšlet drogy, aby se nedostaly na trh

Podobně velkolepá prohlášení se objevovala prakticky všude. U novinářů to lze ještě pochopit. Mohou se „honit za senzací“ a záměrně zveličovat, jak to ostatně z podstaty své praxe dělají. Anebo jsou skutečně v šoku: zatímco poslední dekády blahosklonně radili manuálně pracujícím, řidičům a dalším podobným profesím, že budou brzy nahrazeni roboty, nejblíž nahrazení jsou teď právě oni.

Když ale podobnému klamu podlehne i inženýr Googlu, a to dokonce takovým způsobem, že kvůli němu přijde o své lukrativní místo, je to na pováženou. Možná ještě víc než nově demonstrované schopnosti umělé inteligence.