V souvislosti s nástupem ChatGPT a dalších forem generativní AI se často přemýšlí o tom, jak se změní trh práce, respektive kdo o ni v budoucnu přijde. A zatímco se předchozí modernizace vždy dotkla lidí s nejnižší kvalifikací, tentokrát mohou pociťovat obavy i lidé na opačném konci spektra. Vedle nejrůznějších autorů obsahu to mohou být například právníci.

I když pokusy o zapojení umělé inteligence do soudních sporů existují už delší dobu, kvůli vlivu soudních rozhodnutí na životy lidí bude AI sloužit nejspíše jen jako pomocník. Ale i v této roli vás může doslova stát místo. Vyprávět by o tom mohl newyorský právník Steven Schwartz. I když o jeho osudu budou rozhodovat profesní svazy, už nyní je jeho pověst přinejmenším dosti pošramocená.

Jak informuje agentura Reuters, vše začalo poměrně obvyklou žalobou o náhradu škody. Pasažér žaloval aerolinky Avianka, na jejichž palubě mělo dojít k poranění kolene špatně zajištěným vozíkem na rozvoz jídel. Protože k incidentu došlo už v roce 2019, právníci letecké společnosti odmítali platit náhradu s odkazem na promlčení.

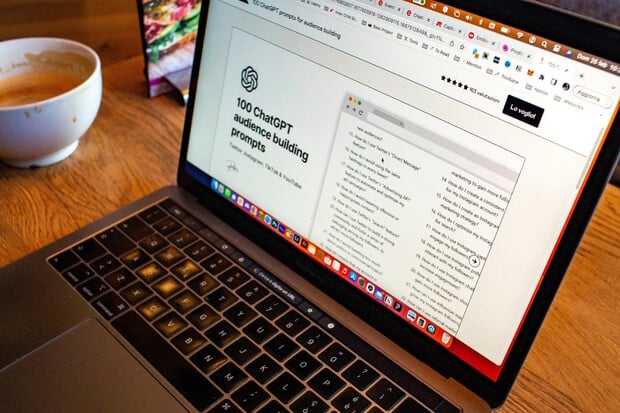

Případ tak skončil u právní kanceláře Levidow, Levidow & Oberman a již zmiňovaného Schwartze. Pro právníka s třicetiletou praxí by to měla být snadná práce. K otevření případu mu jen stačí najít precedentní posudek, který by například prodlužoval promlčecí lhůtu u případu s poškozeným zdravím. Namísto klasického hledání v archivu nebo použití specializovaného softwaru pro právníky sáhl Schwartz po ChatGPT.

Ačkoli právník, zjevně si nepřečetl úvodní ustanovení, v němž autoři ChatGPT důrazně varují, že může dávat nepřesné, zavádějící nebo zcela smyšlené odpovědi. Tou bylo v tomto případě tvrzení o existujícím rozsudku v případu Varghese versus China Southern Airlines, který popisoval obdobný případ rozhodnutý ve prospěch cestujícího. ChatGPT byl opravdu důkladný: dodal jednací číslo, hlavičku rozhodnutí s údaji soudu a zúčastněných stran i výňatky z rozhodnutí, které přesně pasovaly k stávajícímu případu. A kde je problém? Žádný takový případ se nikdy nestal.

Novinář se snažil přimět AI k vyhlazení lidstva. Naštěstí byla od Microsoftu – Glosa

Schwartz pak celou situaci korunoval tím, že se výstup chatbota snažil ověřit otázkou, zda jde o skutečný případ. ChatGPT mu neochvějně tvrdil, že ano a vymýšlel si neexistující zdroje. Advokáty protistrany ani soudce však nepřesvědčil. Steven Schwartz má prozatím pozastavenou činnost a o jeho osudu bude rozhodovat profesní komora.

Případ je podle odborníků dalším varováním, že řada lidí nechápe, jak AI založená na velkých jazykových modelech funguje. Její schopností je generovat přesvědčivě znějící texty, neřeší však už jejich pravdivost. Poněkud znepokojivé je v tomto ohledu pomyšlení, že i přes četná varování takto dokáže „přelstít“ i zkušeného právníka.